Bài toán so sánh 9,9 so và 9,11 gây sốt trở lại khi người dùng thử nghiệm với DeepSeek.

Thử thách toán học đơn giản 9,9 so với 9,11 đã khiến nhiều mô hình AI gặp phải sự cố trong việc đưa ra câu trả lời chính xác. Trong khi DeepSeek khẳng định rằng 9,9 lớn hơn, các chatbot khác như ChatGPT, Meta AI và Google Gemini đều đưa ra kết luận sai rằng 9,11 lớn hơn.

Kể từ giữa năm ngoái, câu hỏi này đã trở thành một bài toán “hại não” gây xôn xao cộng đồng mạng xã hội và thử thách trí tuệ của nhiều hệ thống AI. Mặc dù về lý thuyết, phép so sánh này khá đơn giản, song không ít chatbot đã trả lời sai.

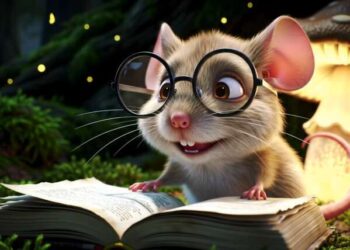

ChatGPT, Meta AI và Google Gemini đều cho rằng 9,11 lớn hơn. Khi thử nghiệm lại vào tháng 2, những mô hình này vẫn không thay đổi câu trả lời.

Với sự xuất hiện của DeepSeek từ cuối tháng 1, nhiều người đã thử nghiệm bài toán này với AI mới từ Trung Quốc. DeepSeek giải quyết vấn đề này một cách chi tiết: đầu tiên so sánh phần nguyên và phần thập phân, rồi kết luận “0,90 > 0,11, vì vậy 9,9 > 9,11”.

Câu trả lời của DeepSeek, ChatGPT, Gemini và Meta AI được trình bày như sau: DeepSeek đúng, còn ba mô hình còn lại đều sai.

Trước đó, khi bài toán này xuất hiện ở Trung Quốc vào tháng 7/2024, hai chatbot phổ biến Kimi của Moonshot AI và Baixiaoying của Baichuan cũng trả lời sai rằng 9,11 lớn hơn. Sau khi người dùng phản ánh, cả hai chatbot đã sửa thuật toán và xin lỗi, đồng thời giải thích rằng lỗi xuất phát từ cách “suy nghĩ chuỗi” mà AI sử dụng, trong đó nó chia nhỏ con số sau dấu phẩy và so sánh 11 với 9, từ đó đưa ra kết luận sai.

Ngoài ra, một số AI cần các bước tính toán phức tạp hơn. Ví dụ, Qwen LLM của Alibaba sử dụng Python Code Interpreter để tính toán, trong khi Ernie Bot của Baidu phải trải qua sáu bước giải thích mới đưa ra câu trả lời đúng.

Theo Wu Yiquan, nhà nghiên cứu tại Đại học Chiết Giang, lý do AI không giỏi toán là vì các mô hình ngôn ngữ lớn (LLM) không được thiết kế để làm toán, mà chỉ dựa vào dự đoán từ dữ liệu đào tạo. “Một số LLM có thể trả lời đúng trong các bài toán toán học nhờ ‘nhiễm dữ liệu’, tức là chúng đã ghi nhớ câu trả lời nhờ vào việc xuất hiện các câu hỏi tương tự trong quá trình huấn luyện,” Yiquan chia sẻ. “Trong thế giới AI, mọi thứ đều được mã hóa, vì vậy bất kỳ thay đổi nào trong câu hỏi cũng có thể ảnh hưởng đến kết quả.”

Các chuyên gia khuyến cáo người dùng không nên quá tin tưởng vào các mô hình AI, vì chúng đôi khi đưa ra câu trả lời sai hoặc “ảo giác”, tức là bịa ra câu trả lời sao cho có vẻ hợp lý.

Vào ngày 20/1, công ty khởi nghiệp DeepSeek của Trung Quốc đã ra mắt mô hình V3 miễn phí, cùng với mô hình R1 được đào tạo trên các chip Nvidia cũ, mở mã nguồn 100% và rẻ hơn tới 96,4% so với OpenAI o1, nhưng vẫn duy trì hiệu suất tương tự. DeepSeek cho biết họ chỉ mất 2 tháng và chi phí 5,6 triệu USD để phát triển mô hình AI sử dụng chip H800 của Nvidia. Phiên bản V3 của DeepSeek thậm chí đã vượt ChatGPT, trở thành ứng dụng được tải về nhiều nhất trên App Store, trong khi giá trị của Nvidia giảm gần 600 tỷ USD.