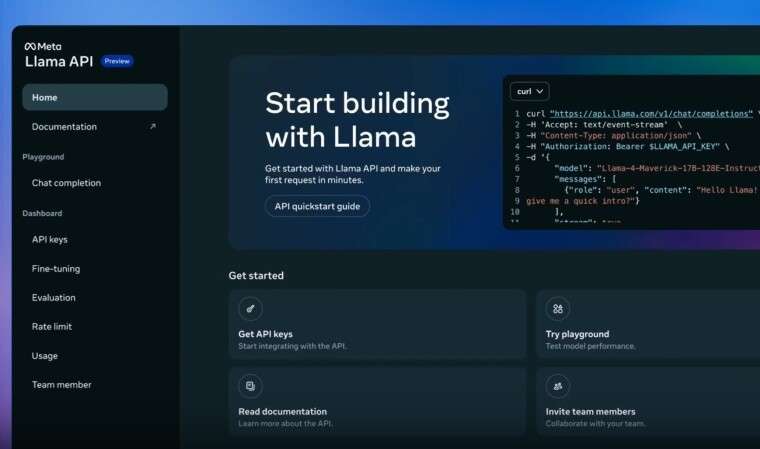

Trong khuôn khổ hội nghị LlamaCon đầu tiên, Meta đã công bố hàng loạt công cụ hỗ trợ lập trình viên tiếp cận dễ dàng hơn với dòng mô hình Llama, đặc biệt là sự ra mắt của Llama API – hiện đã có mặt dưới dạng bản xem trước miễn phí với số lượng giới hạn.

Llama API cho phép nhà phát triển dễ dàng thử nghiệm các mô hình mới như Llama 4 Scout và Llama 4 Maverick. Giao diện lập trình đơn giản với SDK nhẹ dành cho TypeScript và Python, cùng khả năng tương thích với SDK của OpenAI, giúp việc chuyển đổi các ứng dụng từ nền tảng khác sang Llama trở nên mượt mà hơn bao giờ hết.

Meta đang hợp tác với hai cái tên lớn trong lĩnh vực phần cứng AI – Cerebras và Groq – để tối ưu hóa hiệu suất xử lý cho Llama API.

Đặc biệt, mô hình Llama 4 Cerebras đạt tốc độ tạo token hơn 2.600 token/giây, theo dữ liệu từ nền tảng Artificial Analysis. Con số này nhanh hơn gấp 20 lần so với ChatGPT (130 token/giây) và hơn 100 lần so với DeepSeek (25 token/giây). Để so sánh, phiên bản Llama 4 Scout chạy trên Groq đạt khoảng 460 token/giây – tuy chậm hơn Cerebras, nhưng vẫn vượt xa các giải pháp dựa trên GPU hiện nay.

Ông Andrew Feldman, CEO kiêm đồng sáng lập của Cerebras, chia sẻ:

“Chúng tôi tự hào mang đến Llama API tốc độ suy luận nhanh nhất thế giới. Các nhà phát triển ứng dụng thời gian thực và hệ thống AI tự động cần tốc độ. Với Cerebras tích hợp trong Llama API, họ có thể xây dựng những hệ thống AI mà GPU truyền thống không thể theo kịp.”

Các nhà phát triển quan tâm có thể trải nghiệm khả năng xử lý siêu tốc này bằng cách chọn Cerebras trong tùy chọn mô hình bên trong Llama API. Llama 4 Scout trên nền tảng Groq cũng đã sẵn sàng thử nghiệm, phù hợp với những ứng dụng cần tốc độ cao hơn GPU nhưng chưa yêu cầu đến mức “tối thượng” như Cerebras.