GPT-4.5 khiến hơn 70% người thử nhầm lẫn với con người

Trong tuần qua, truyền thông thế giới xôn xao trước thông tin một chatbot AI đã chính thức vượt qua Turing Test – bài kiểm tra được xem như “thước đo vàng” cho trí tuệ nhân tạo. Thông tin này đến từ một nghiên cứu tiền ấn phẩm (chưa được phản biện khoa học) của hai nhà khoa học nhận thức Cameron Jones và Benjamin Bergen, thuộc Đại học California San Diego (UCSD).

Nghiên cứu này thử nghiệm 4 mô hình ngôn ngữ lớn (LLMs): ELIZA, GPT-4o, LLaMa-3.1-405B và GPT-4.5. Trong đó, GPT-4.5 khiến người tham gia thử nghiệm nhầm tưởng là con người tới 73% số lần. Mô hình LLaMa-3.1-405B đạt 56%, trong khi hai mô hình còn lại – ELIZA và GPT-4o – chỉ đạt 23% và 21%.

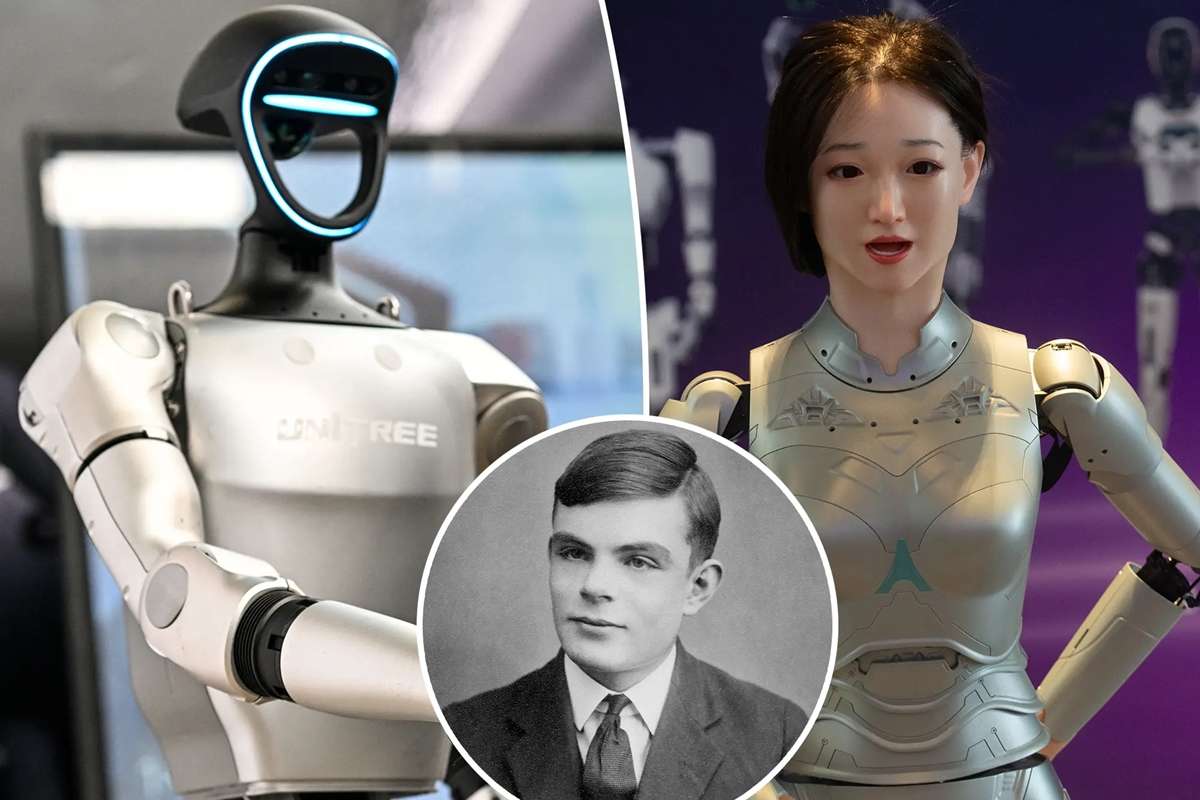

Turing Test là gì và tại sao vẫn gây tranh cãi?

Turing Test do nhà toán học Alan Turing đề xuất vào năm 1950, được thiết kế như một “trò chơi bắt chước” để xem liệu một cỗ máy có thể bắt chước hành vi của con người đến mức không thể phân biệt được hay không. Theo đó, nếu người tham gia không thể phân biệt đâu là người và đâu là máy trong một cuộc trò chuyện, thì AI đã “vượt qua” bài kiểm tra.

Tuy nhiên, bài kiểm tra này vẫn gây nhiều tranh cãi trong giới học thuật. Có bốn điểm phản đối chính:

Hành vi không đồng nghĩa với tư duy: Một số nhà nghiên cứu cho rằng việc một AI bắt chước hành vi giống người không có nghĩa là nó đang “suy nghĩ” như con người.

Não người không phải là máy: Turing cho rằng bộ não có thể được giải thích bằng các quy trình cơ học, nhưng nhiều học giả bác bỏ ý kiến này.

Quá trình xử lý khác biệt: AI và con người có cách tiếp cận và xử lý vấn đề rất khác nhau, khiến việc so sánh trở nên khập khiễng.

Giới hạn về hành vi: Chỉ đánh giá một hành vi giao tiếp đơn lẻ không đủ để xác định trí tuệ thực sự.

GPT-4.5 thông minh như người? Chưa hẳn là vậy

Nghiên cứu từ UCSD không khẳng định GPT-4.5 có trí thông minh như con người. Thay vào đó, họ cho rằng mô hình này “có thể thay thế vai trò của con người mà người khác không nhận ra sự khác biệt”. Nói cách khác, nó giỏi bắt chước, nhưng không nhất thiết hiểu biết như người thật.

Ngoài ra, nghiên cứu cũng tồn tại một số điểm hạn chế:

- Thời gian thử nghiệm chỉ 5 phút – quá ngắn để đánh giá khả năng tư duy sâu.

- Các mô hình được gán “nhân dạng giả định” – nhưng không rõ điều này ảnh hưởng thế nào đến kết quả.

- Chưa được phản biện khoa học – nên kết luận vẫn chỉ mang tính tham khảo.

Tương lai của AI sau “bước nhảy” này là gì?

Việc GPT-4.5 vượt qua Turing Test khiến nhiều người đặt câu hỏi: Nếu một AI có thể đánh lừa phần lớn người dùng, thì điều gì sẽ xảy ra tiếp theo?

Dù chưa thể khẳng định GPT-4.5 hay bất kỳ AI nào khác có thể “suy nghĩ” như con người, nhưng rõ ràng ranh giới giữa máy và người đang mờ dần. Điều này đặt ra hàng loạt vấn đề về đạo đức, pháp lý và cách chúng ta ứng xử với những hệ thống ngày càng “giống người” hơn.